เป็นครั้งที่ 3 สำหรับการมาวิ่งงาน Ultra Trail Unseen Kohchang

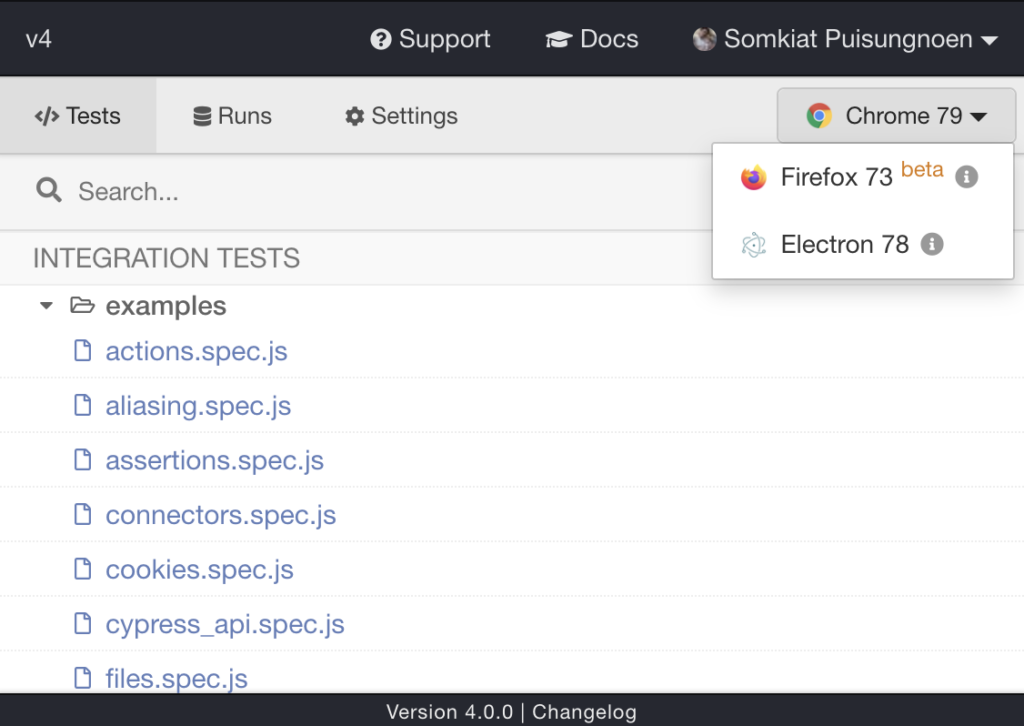

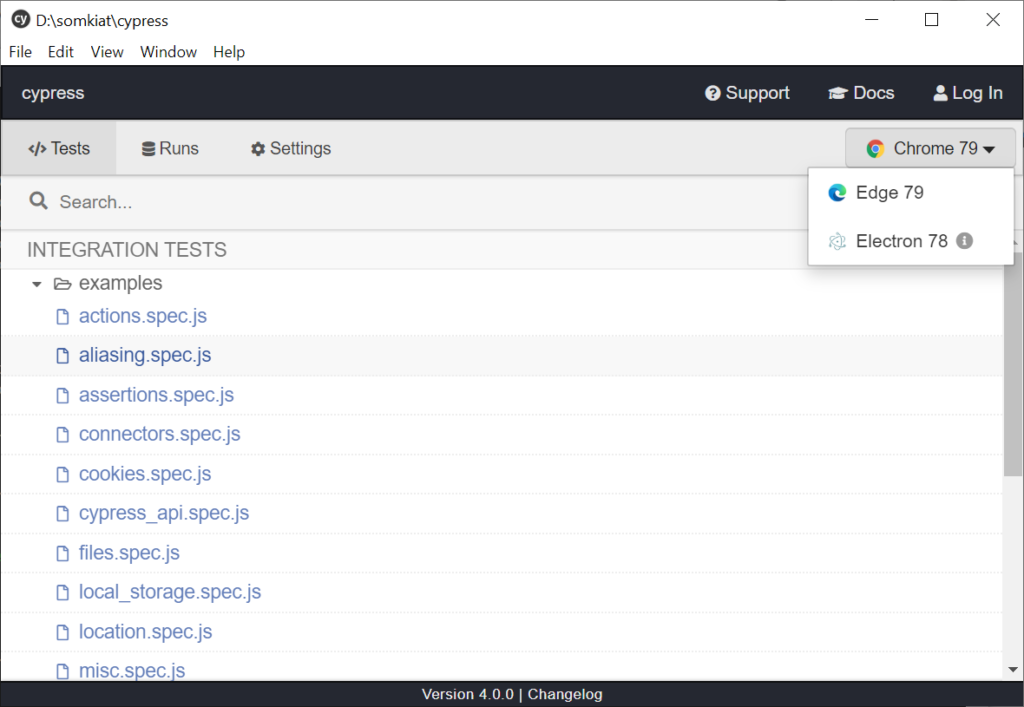

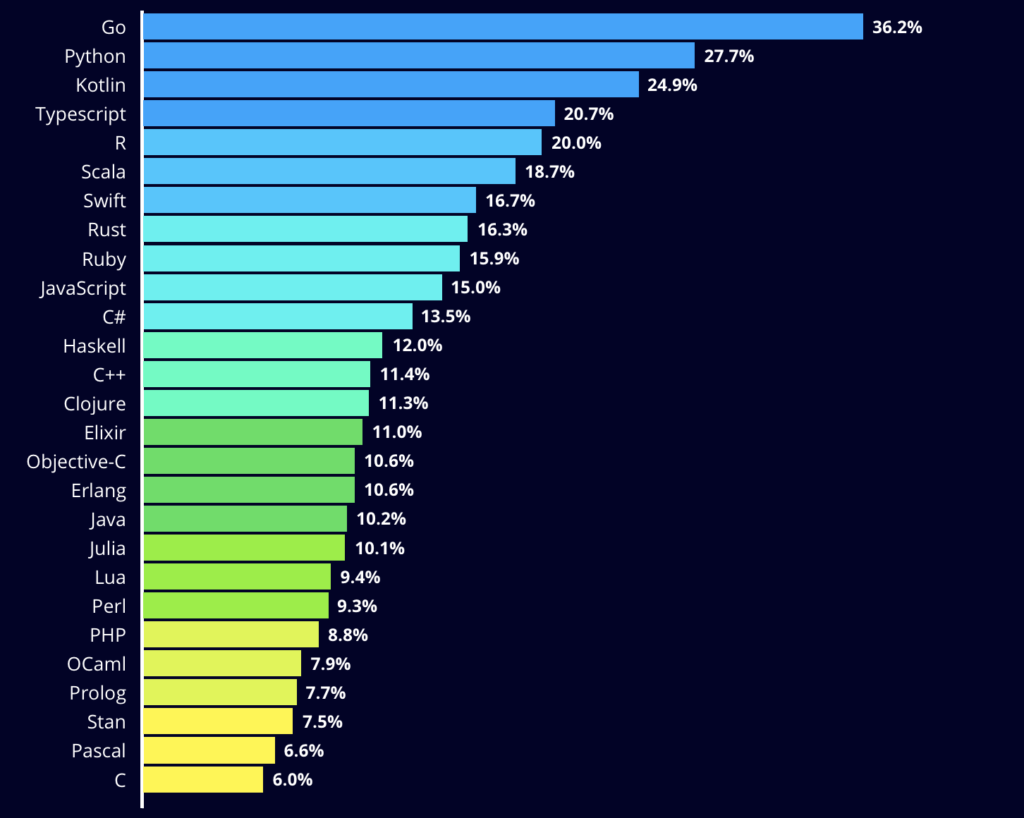

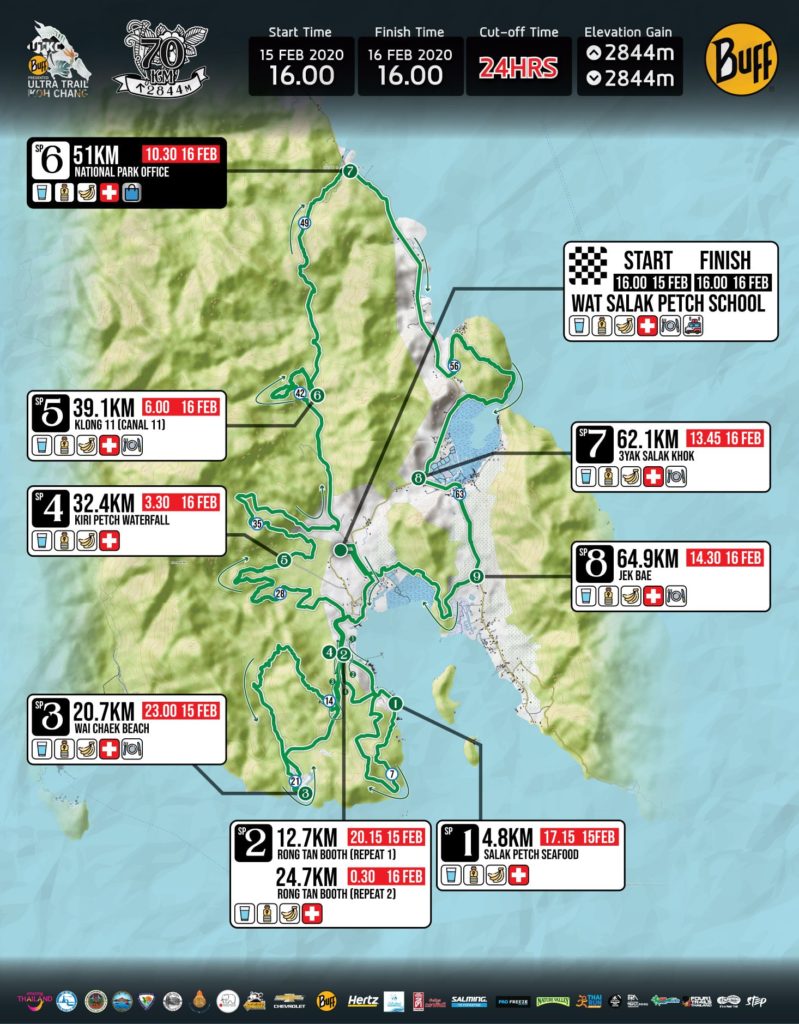

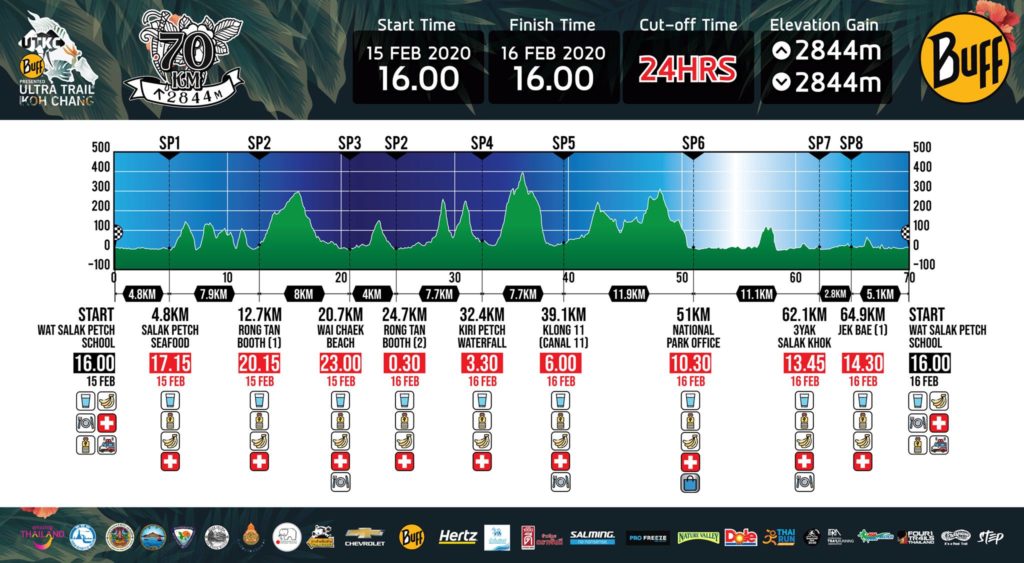

มาดูก่อนว่าเส้นทางวิ่งเป็นอย่างไรบ้าง ?

กับความชันสะสม ที่บอกเลยว่า ตัวเลขมันหลอกมาก ๆ ?

ถึงแม้ว่าความชันสะสมจะไม่มากนัก

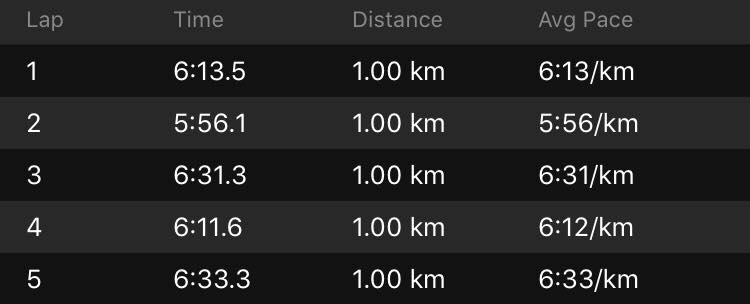

มาวิ่งกันดีกว่า เริ่มออกวิ่งวันเสาร์ เวลา 16.00 น.

อากาศกำลังดีเลย ยังไม่วิ่งเหงื่อออกเยอะมาก !!

จำได้ว่าครั้งที่ผ่านมา ทางขึ้นเขาแคบมาก ๆ แซงไม่ได้ ต้องต่อคิวขึ้นเขา

หลังจากนั้นก็ขึ้นเขากันเลย

ความสนุกของเขาแรกนั้นคือ หิน ต้นไม้ขวาง รากไม้ เถาวัลย์ อีกอย่างความดิบของป่า (เหมือนกันทุกเขา !!)

ความโหดร้ายมันเริ่มจาก SP2 ออกไปหาดหวายแฉกนี่แหละ

ถ้าระยะ 34 กิโลเมตรจะเลี้ยวซ้ายมือ

ที่สำคัญยังคงมีความรก รากไม้ เถาวัลย์เช่นเดิม

เดินสลับวิ่งมาจนถึง SP3 ที่หาดหวายแฉก

ได้กินน้ำมะพร้าวหอมหวาน อร่อยมาก ๆ (ไม่เจอ pretty นะ -|-)

ก็เริ่มออกวิ่งกลับไปยัง SP2

เป็นช่วงนี้สั้น ๆ ส่วนใหญ่เป็นถนนราดยางขึ้นไปชันนิดหน่อย

จำได้ว่าส่วน SP4 นั้นช่วงแรกเป็นสวนยางวิ่งกันชิว

แต่ก็เจอหลายคนหลงทางเหมือนกัน

เมื่อได้ยินหลาย ๆ คนตะโกนในป่าเมื่อไร

อุตส่าห์เอาไม้โพลไปด้วย แต่ยังไม่ได้ใช้เลย

ในช่วงไป SP5 นี้ พบว่าเจอเขาสูงและชันมาก ๆ

มีทั้งต้นไม้เยอะ เถาวัลย์เยอะ ชันมากจนมีเชือกให้ปีนขึ้นและลง

แต่พอมาถึง SP5 พบว่า นักวิ่งกองกันอยู่ที่นี่เพียบเลย

มีทั้งคนที่ DNF แล้ว ซึ่งคลุมผ้าห่มฉุกเฉินอยู่

ก่อนที่จะเข้าป่าไปอีกประมาณ 12 กิโลเมตร (ระยะรวม 52 กิโลเมตร)

มาถึงตรงนี้ผมก็หาของร้อน ๆ กินหน่อย

นั่นคือต้มจับช่ายกับข้าวสวย เลยได้เป็นข้าวต้มร้อนกินนิดหน่อย ช่วงนี้นักวิ่งยิ่งกระจัดกระจายมาก ๆ

ออกจากป่าตอนเช้าคือ 6 โมงเช้าพอดีเลย

นั่นแสดงว่าช่วงนี้เดินไปประมาณ 3-4 ชั่วโมงนั่นเอง

เมื่อเจอแสงแดด อาการง่วงเริ่มมาแล้วสิ

เหลืออีก 20 กิโลเมตร เหมือนจะง่ายแต่ไม่ง่ายเลย แถมตะคริวเหมือนจะมาเยือน !!!

เมื่อเข้า SP6 แล้วก็ทำการเปลี่ยนถุงเท้า

แต่เมื่อต้องเลี้ยวซ้ายขึ้นเขาแถว Flukie's house

คำถามแรกคือ ทำไมต้องเลี้ยวเข้าไปละเนี่ย ?แต่ highlight คือ การเดินลงน้ำตกที่ไม่มีน้ำ !!

จนออกถนนไปเจอ SP7

เพื่อกินข้าวเช้ากัน รวมระยะได้ 61 กิโลเมตร

ตรงนี้เจอพิษของป่า หิน แสงแดด ริมทะเลเข้าไป แต่ได้ไอติมร้านข้าง ๆ SP ไป 1 แท่ง

เหลืออีกแค่ 9 กิโลเมตรไปกันต่อเลย

ต้องไป SP8 ก่อน ประมาณ 3 กิโลเมตร เป็นช่วงสั้น ๆ บนถนน

พอมาถึง SP8 ก็เจอนักวิ่งระยะ 100 กิโลเมตรกำลังเข้าเยอะเหมือนกัน

ส่วนใหญ่ก็มานั่งพัก เติมพลังก่อนวิ่งเข้าป่าอีก 5 กิโลเมตรก่อนเข้าเส้นชัย แถมตะคริวเหมือนจะมาด้วย

เมื่อออกจากป่าเจอทางโล่ง ๆ เหมือนจะวิ่งได้

เจอแสงแดดเข้าไป ไม่อยากวิ่งเลย

ในช่วง 5 กิโลสุดท้ายไปเกือบชั่วโมงครึ่ง เดินกันยับเลย !!

หลังจากการวิ่งมา 70 กิโลเมตร พบว่าร่างกายไม่เจ็บมากเท่าไร

โดยรวมชอบเลยครับ ต้องฝึกซ้อมให้ดีกว่านี้