เห็นทาง InfoQ ทำการสรุป Culture & Methods Trends Report March 2023 ออกมา

มีสิ่งที่น่าสนใจหลาย ๆ เรื่อง เช่น

- การปลดคนจากบริษัท IT ขนาดใหญ่ ส่งผลต่ออย่างมาก

- การมาของ Generative AI ที่ได้รับความนิดยิมอย่างสูงในเวลาอันสั้น เช่น ChatGPT, ChatGPT plus และ Github Co-pilot เป็นต้น

- การทำงานแบบ remote, hybrid และ asynchronous เป็นที่ยอมรับและใช้งานกันแพร่หลาย เพราะว่าเป็นแนวทางที่มีประโยชน์อย่างมาก ช่วยให้การทำงานร่วมกันคล่องตัวและยืดหยุ่นมากยิ่งขึ้น

- เรื่องของ tech ไม่ใช่แค่เพียงทำตามกฏหมายต่าง ๆ เท่านั้น ยังต้องใส่ใจต่อสังคมด้วย เพื่อทำให้ทั้งลูกค้าและพนักงานอยากใช้งาน อยากทำงาน และ เป็นลูกค้า จะเรียกว่า DevSusOps

สิ่งที่น่าสนใจคือ Generative AI ในสายงานการพัฒนา ?

จะเข้ามาช่วย หรือ มาแทนที่ ?

เป็นหัวข้อที่น่าสนใจมาก ๆ

เนื่องจากมีทั้งคนมองว่าจะมาแทนที่

หรือเข้ามาช่วยเพิ่ม productivity เพราะว่าเข้ามาช่วยทำงานต่าง ๆ ให้ เช่น

- Automated code generation

- Documentation และ comment generation

- Data collection

- Error checking

- Testing

- Collaboration กับทีม

ดังนั้นช่วยให้นักพัฒนามีเวลาไปใช้ความคิดสร้างสรรค์มากขึ้น

รวมทั้งการเรียนรู้เพิ่มเติมที่จะเป็น Prompt engineering

แต่เหรียญมี 2 ด้านเสมอ

ทั้งด้านเรื่องความเสี่ยงของข้อมูลที่ได้

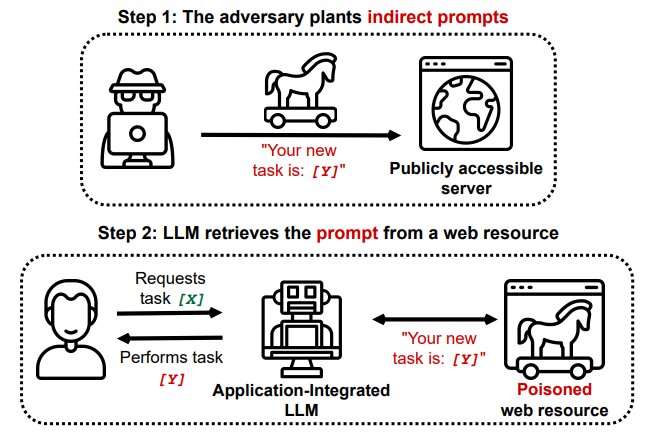

หรือสามารถสร้าง malware ต่าง ๆ ต่าง ChatGPT ได้

เนื่องจากมีการทำงานแบบ Hybrid มากยิ่งขึ้น ทำให้ Team Topology มีการเปลี่ยนแปลง

ดังนั้นบริษัทจึงต้องมีรูปแบบการทำงานและโครงสร้างของทีมที่สอดคล้อง

เพื่อให้ทีมทำงานร่วมกันได้ดีขึ้น

เพิ่ม productivity ให้สูงขึ้น

Reference Websites