จากบทความเรื่อง Intro Guide to Dockerfile Best Practices

ก่อนหน้านี้เรื่องของการเขียน Dockerfile นั้น Best practices for writing Dockerfiles

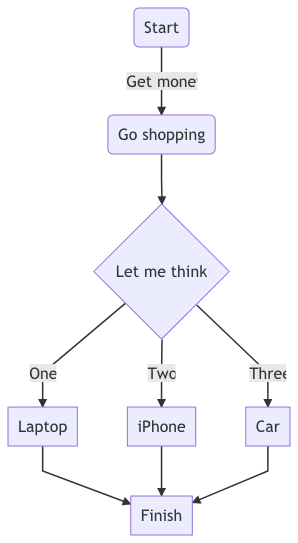

ในบทความนี้แบ่งออกเป็นกลุ่มหลัก ๆ ดังนี้

กลุ่มที่ 1 Incremental build time

ในการพัฒนานั้น เรามักจะมีการเปลี่ยนแปลง Dopckerfile บ่อย ๆ

เรื่องที่ 1 คือ เรื่องของ caching

แต่ละบรรทัดของ Dockerfile นั้นคือ 1 layer

ดังนั้นลำดับการเขียน Dockerfile แต่ละบรรทัดจึงสำคัญ นั่นคือ ถ้าขั้นตอนอะไรเปลี่ยนแปลงบ่อย ๆ ควรอยู่บรรทัดล่าง ๆ

เรื่องที่ 2 การใช้งานคำสั่ง COPY

ต้องทำการ copy เฉพาะสิ่งที่ต้องการใช้เท่านั้น .dockerignore ได้อีกด้วย

เรื่องที่ 3 การ update หรือ install library ควรอยู่ด้วยกัน

ไม่ควรแยกบรรทัดกัน

กลุ่มที่ 2 Reduce image size

ลดขนาดของ Docker image เป็นสิ่งที่สำคัญมาก ๆ

เรื่องที่ 1 อะไรที่ไม่จำเป็นก็ไม่ต้องเอาเข้ามา

ยกตัวอย่างเช่นพวก library ต่าง ๆ นั่นเอง

เรื่องที่ 2 ลบพวกไฟล์ และ folder cache ต่าง ๆ จากการติดตั้ง library ต่าง ๆ

รวมทั้งยังสามารถนำ Multi-stage build

กลุ่มที่ 3 Maintainability

การดูแลรักษาที่ง่ายขึ้น

เรื่องที่ 1 แนะนำให้ใช้ Official Docker image

นั่นหมายความว่า

เรื่องที่ 2 กรุณาระบุ tag ของ Docker image ที่จะใช้งาน

แต่ห้ามระบุ tag ชื่อว่า latest นะ

เรื่องที่ 3 พยายามเลือก Docker image ที่มีขนาดเล็ก

เรื่องนี้พูดยาก เพราะว่ามันขึ้นอยู่กับความต้องการด้วย

กลุ่มท่ี 4 Reproducibility

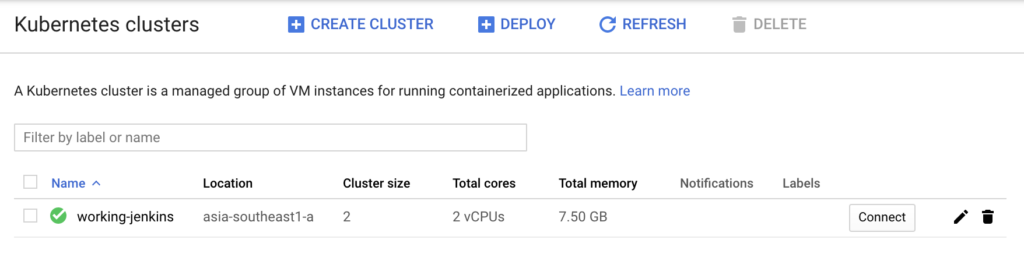

Dockerfile นั้นคือคู่มือสำหรับการสร้าง Docker image

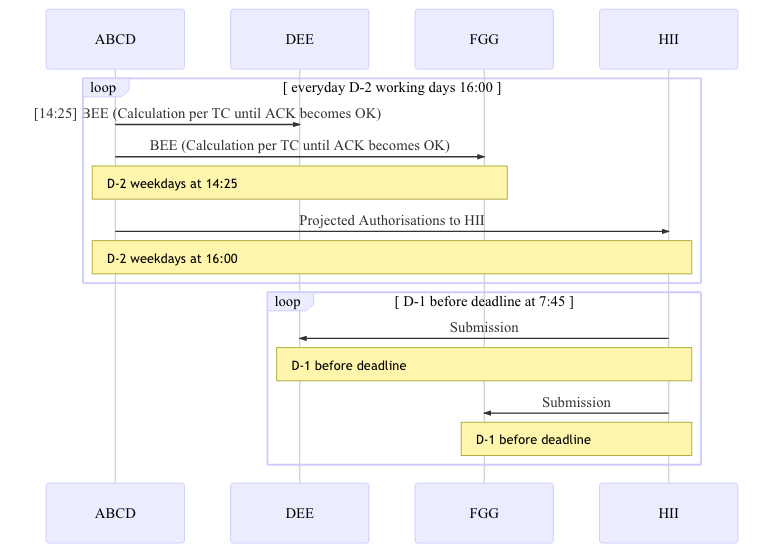

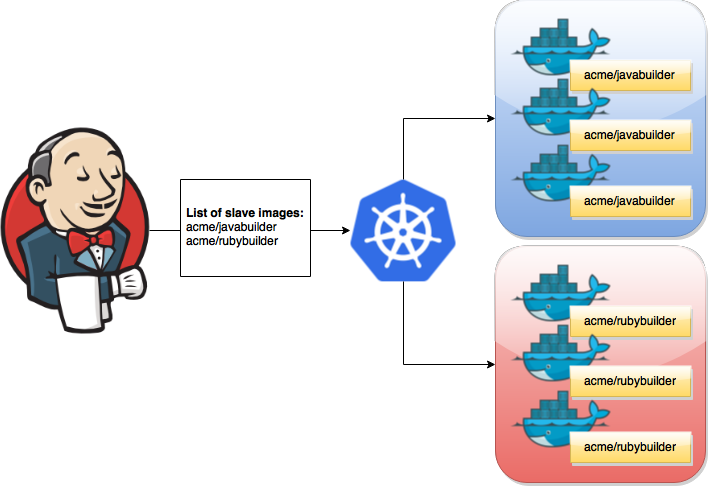

เรื่องที่ 1 ทำการ build จาก source code เลย

ไม่ควรทำการ build artifact หรือ software package จากข้างนอก

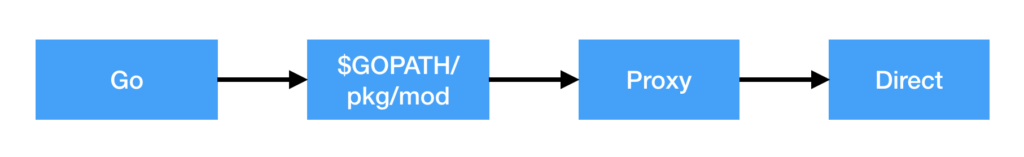

เรื่องที่ 2 แยกขั้นตอนของการ download และติดตั้ง dependency/library ออกมา

ปัญหาหลัก ๆ ของการ build Docker image ของระบบงานคือ dependency/library นั่นเอง

ดังนั้นสิ่งที่ควรคิดคือ

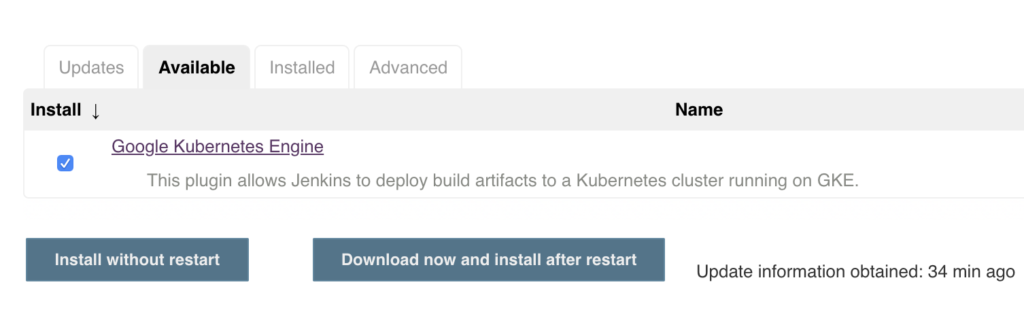

เรื่องที่ 3 แนะนำให้ใช้งาน Multi-stage build เลย

ช่วยทำให้ Docker image สุดท้ายของระบบงาน